機械学習・AI論文を入力してみた!話題のDiffusion Modelで画像生成の実験

最近、Diffusion modelが画像生成技術の分野で注目を集めています。特に、Stable diffusion v1.5はその性能の高さから多くのクリエイターや研究者に使われています。そこで、今回は機械学習・AI系の論文を入力して、そのイメージがどのように画像に反映されるのか実験してみました。本記事では、実験の手順と結果を紹介します。

論文を入力することの意義

- 視覚的表現の可能性: 機械学習やAIの論文は、しばしば技術的かつ抽象的な内容が含まれており、理解するのが難しいことがあります。論文を入力して画像を生成することで、その内容を視覚的に表現することができ、理解しやすくなる可能性があります。

- コミュニケーションツール: 複雑な論文の内容を画像に変換することで、一般の人々や専門家以外の人々とも議論を行いやすくなります。これにより、多様なバックグラウンドを持つ人々とのコラボレーションやアイデアの共有が促進されるでしょう。また、画像が教育やプレゼンテーションの資料として活用されることで、より広い範囲の人々に技術や研究成果を伝えることができます。

- クリエイティブな発想: 論文を入力して画像を生成することで、論文の内容を直接的なイメージとして捉えることができます。これにより、新たな視点や発想が生まれることが期待されます。また、異なる論文の画像を組み合わせることで、新しいアイデアや研究の方向性を模索することも可能になります。

- 研究成果の普及: AIや機械学習の研究成果は、社会全体に利益をもたらすことが期待されていますが、専門的な知識がないと理解が難しいため、広く普及するのが難しい面があります。論文を入力して生成された画像を用いることで、専門家でない人々にも研究内容を直感的に理解してもらいやすくなり、研究成果の普及が促進されるでしょう。

- モデルの評価と改善: 論文を入力して画像を生成する実験を通じて、Diffusion modelやその他の画像生成モデルの性能を評価することができます。生成された画像が論文の内容と一致しているかどうかを検証することで、モデルの改善点や限界を明らかにし、今後の研究や開発に役立てることができます。

このように、論文を入力して画像を生成することには、視覚的表現の可能性の拡大やコミュニケーションツールとしての活用、クリエイティブな発想の促進、研究成果の普及の促進、モデルの評価と改善など、さまざまな意義があります。

実験手順

- 論文の選定: まず、最近注目されている機械学習・AI系の論文をいくつか選定しました。選ばれた論文は以下の通りです。

Attention Is All You Need (https://arxiv.org/abs/1706.03762)

Sequence to Sequence Learning with Neural Networks (https://arxiv.org/abs/1409.3215)

ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators (https://arxiv.org/abs/2003.10555)

Poor Man’s BERT: Smaller and Faster Transformer Models (https://arxiv.org/abs/2004.03844v1?fbclid=IwAR1lzNdGGuaZeJQd8uaX6N6a4W6381RJiIa_0VTt9VWxkC4Z3z5DgPByhHQ)

Are Transformers Effective for Time Series Forecasting? (https://arxiv.org/abs/2205.13504) - 入力の選定: 選定した論文それぞれについて、タイトルを入力としました。タイトルは、主題やキーワードが分かる程度の長さで、Diffusion modelに入力しやすいようにしています。

- 生成モデルの準備: 入力となるタイトルを決定した後、Stable diffusion v1.5を使用して画像生成を行うための環境を整えました。これには、公式ドキュメントやhugging faceからモデルや関連コードをダウンロードし、必要なパッケージをインストールしました。

- 画像生成の実行: それぞれの論文要約をStable diffusion v1.5に入力し、生成される画像を確認しました。また、パラメータ(batch count)を調整して9枚の画像を生成し、出力結果のバリエーションを観察しました。

結果

Attention Is All You Need

ミームのような文字画像が出力された.この論文タイトルはキャッチーだが,中身を言い表すのは"Attention"というワードのみなのでイメージの形成が難しかったか・・・

Sequence to Sequence Learning with Neural Networks

DNAのような鎖構造をもつ連続的な図が生成された.何となくseq2seqのイメージを表している感じがする.論文タイトルに"Sequence to Sequence"が入っていることから,このワードに引っ張られているだけなのかもしれない.

ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators

2つの画像で曼荼羅のようなパターンが出現.ELECTRAは汎用言語モデルに関する論文で,タイトルにも"Generators"が入っているので,円形で周りに何かが生えてくるようなパターンが表れることには納得感があった(筆者にとっては).

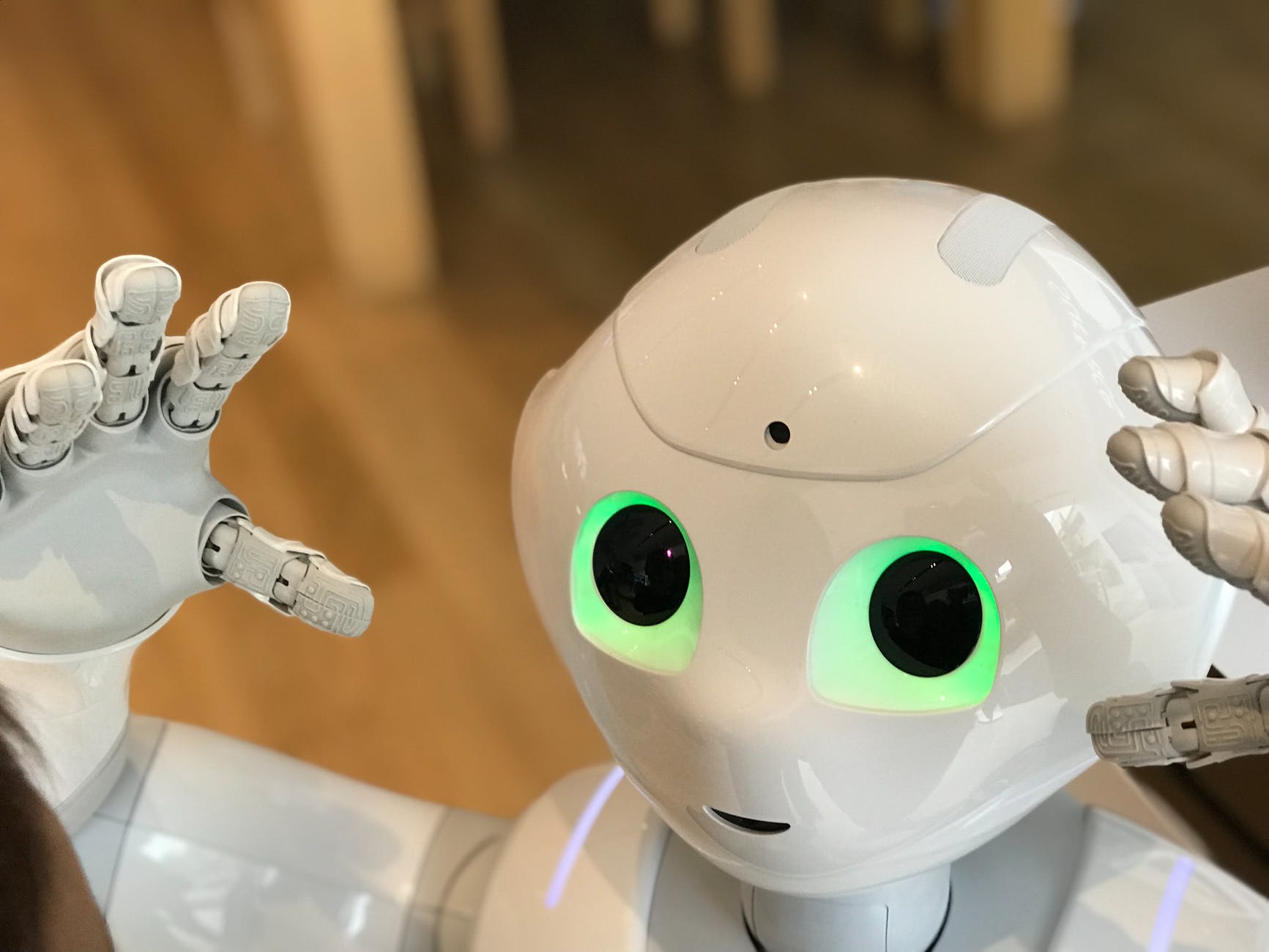

Poor Man’s BERT: Smaller and Faster Transformer Models

全体的にロボットのような画像とトラクターの画像が多く出力された.恐らく,タイトルに"Transformer"が入っているため,車がロボに変形する映画のトランスフォーマーを連想し,このような画像が出力されたのだろう.タイトルに"Poor Man’s"が入っているので,それを反映した面白い画像が出てくることを期待したのだが,それほどでもなかった.

Are Transformers Effective for Time Series Forecasting?

こちらもタイトルに"Transformer"が入る論文.やはり映画のトランスフォーマーに引っ張られる傾向があるようだった.青の画像が多いのはなぜだろう."Effective"とか"Time Series Forecasting"に青のイメージでもあるのだろうか・・・?

おわりに

実験を終えての感想は以下のようになります。

まず、Stable diffusion v1.5を使って生成された画像は、驚くほど高品質ではありましたが、論文の内容を視覚的に捉えているとは言えませんでした。ただ、Transformerがタイトルに入っているとロボの画像がでてくるため、この情報を利用して論文を分類するなどの方法はありなのではないかと思いました。

今後の改善としては、タイトルだけでなく、アブスト、あるいはアブストをさらに要約した文章を入力してみてどのような画像が出力されるのかをみていきたいなと思いました。

ディスカッション

コメント一覧

まだ、コメントがありません